ในปัจจุบัน AI เป็นเทคโนโลยีที่ได้รับความนิยมเป็นอย่างมาก หลังจากความก้าวหน้าของเทคโนโลยีทำให้สามารถนำ Deep Learning มาปรับใช้ได้ในชีวิตจริง ด้วยการกลับมาของ Convolutional Neural Networks (CNN)

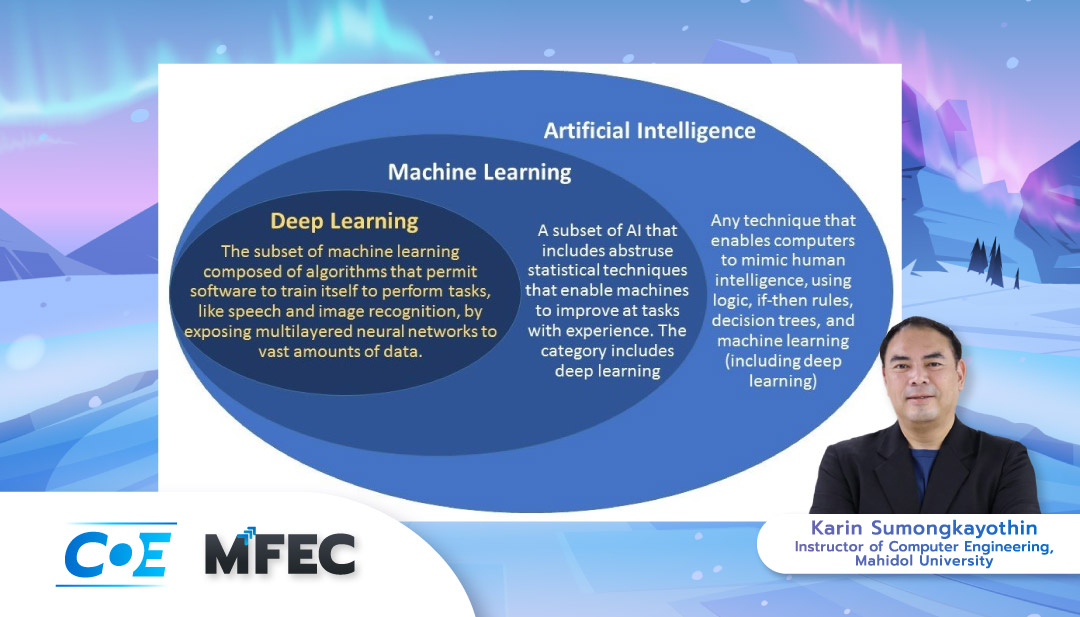

โดยพื้นฐานแล้วมีทฤษฎีที่อธิบายความเกี่ยวข้องของ Machine Learning กับ AI อยู่ 2 ทฤษฎี ทฤษฎีแรกอธิบายว่า Machine Learning และ Deep Learning เป็นส่วนหนึ่งของ AI และทฤษฎีที่สองอธิบายว่า Machine Learning เกี่ยวข้องกับ AI แค่ในส่วนที่เกี่ยวกับการตัดสินใจเท่านั้น

ที่ผ่านมา ได้มีการนำ AI ไปใช้ประโยชน์ในหลายรูปแบบ เช่น เทคโนโลยี Face Recognition, Image Recognition และ Self-Driving Car และมีการนำ Machine Learning ไปประยุกต์ใช้กับแอปที่หลากหลายในสายงาน Cyber Security ไม่ว่าจะเป็น Malware Detection หรือ Anti-Spam

อย่างไรก็ตาม AI ไม่ใช่คำตอบของทุกสิ่ง และไม่สามารถทดแทนการตัดสินใจของมนุษย์ได้ 100%

Machine Learning ที่เป็นกลไกสำคัญของการทำงานของ AI อาศัยข้อมูลในการตัดสินใจและการตัดสินใจเหล่านั้นมีโอกาสที่จะผิดพลาดได้ ทำให้เกิดเป็นช่องโหว่ที่อาจะทำให้เกิดอันตรายหรือสามารถนำไปใช้ประโยชน์ในทางที่ผิดได้ เช่น อุบัติเหตุของรถ Tesla ที่เกิดจากความผิดพลาดในระบบตรวจจับ และเทคโนโลยี Deepfake ที่ใช้ปลอมแปลงเป็นบุคคลสำคัญ

งานวิจัยของ Ian Goodfellow ในปี 2017 ชี้ให้เห็นถึงช่องโหว่ของ Machine Learning ของ CNN ผ่าน Adversarial Example Attack หรือการโจมตี Machine learning โดยการบิดเบือนข้อมูลต้นฉบับ ซึ่งสามารถทำได้หลายวิธี ได้แก่

Fast Gradient Sign Method (FGSM)

การบิดเบือนข้อมูลโดยการเพิ่มน้ำหนักของข้อมูลเพื่อผลักให้ไปอยู่ในเขตข้อมูลที่ผิด โดยการจำแนกประเภทของข้อมูลจะอิงตามน้ำหนักของข้อมูล ทำให้สามารถระบุได้ว่าจะให้ผิดเป็นอะไร แค่ต้องรู้ว่าผลักไปทิศทางไหนเพื่อให้ Network จำแนกข้อมูลเป็นไปตามที่ต้องการ One-Pixel Attack

การบิดเบือนข้อมูลโดยการแก้ไขเพียง 1 พิกเซลในตำแหน่งที่ใช้ในการจำแนกประเภทของข้อมูลจากรูป ไม่สามารถระบุผลลัพธ์ได้อย่างเฉพาะเจาะจง แต่สามารถเปลี่ยนข้อมูลให้เป็นสิ่งที่ไม่ควรจะเป็นได้ ตัวอย่างเช่น ทำให้ Machine Learning อ่าน ถ้วยชา เป็น จอยสติ๊ก

Adversarial Patch

การบิดเบือนข้อมูลโดยการเพิ่มองค์ประกอบอื่น หรือ Patch เข้าไปในข้อมูลต้นฉบับ เช่น การเพิ่มรูปที่ถูกสร้างเพื่อการโจมตีโดยเฉพาะลงไปในรูปเป้าหมาย ก็สามารถเปลี่ยนคีย์บอร์ดเป็นหอยสังข์ได้ เพราะ Patch นั้นมีค่า Feature ที่โดดเด่นกว่าเป้าหมาย ทำให้ Machine Learning ตรวจจับได้เป็นสิ่งที่ Patch กำหนดให้เป็น

นอกจากวิธีการที่ยกมา ก็ยังมีรูปแบบการโจมตีอื่น ๆ อีกมากมาย เช่น 3D Adversarial Example, OCR Adversarial Example, NLP Adversarial Example และ Audio Adversarial Example ซึ่งล้วนสร้างผลกระทบที่อันตราย

Adversarial Attack สามารถทำได้ในทุกกรณีที่มี Input Data หากไม่มีการสร้าง Model ที่ป้องกันการโจมตีแบบ Adversarial Example ที่แข็งแกร่งมากพอ ซึ่งในปัจจุบันประเด็นการรักษาความปลอดภัยของข้อมูลในระบบ AI ยังไม่เป็นที่แพร่หลายในประเทศไทย เนื่องจากส่วนใหญ่จะให้ความสำคัญกับผลลัพธ์จากการประมวลผลและเชื่อมั่นในผลลัพธ์จาก AI มากกว่าที่ควรจะเป็น

สรุปได้ว่า แม้ว่าการใช้ AI จะเป็นสิ่งที่ดี ทำให้สามารถแบ่งเบากำลังคนและงานได้ แต่อย่าเชื่อ AI มาก ควรใช้มนุษย์ตรวจสอบข้อมูลก่อนเสมอ เพื่อให้ได้ข้อมูลที่ถูกต้องและปลอดภัยต่อการใช้งาน